Domenica 18 marzo a Tempe, in Arizona, intorno alle 10 di sera un SUV Volvo XC90 dell’azienda americana Uber ha investito una donna di 49 anni mentre cercava di attraversare la strada, spingendo la sua bici.

Nel video registrato dalla telecamera all’interno dell’auto, si vede la donna comparire improvvisamente sulla strada a pochi metri dall’auto, illuminata dai fari della vettura. L’auto sta viaggiando a 60 km/h su una strada extraurbana dove il limite è di 70. Al momento dell’impatto la donna è voltata verso il lato opposto rispetto al senso di marcia, mentre il passeggero all’interno del mezzo sta distrattamente guardando per terra. Nessuno dei due riesce a rendersi conto della collisione imminente.

Sembrerebbe un normalissimo, seppur tragico, incidente stradale, se non fosse che la macchina in questione non era pilotata dalla persona che si trovava nell’abitacolo, bensì da un sofisticato computer di bordo in grado di condurla come un essere umano.

Il caso di Elaine Herzberg, la donna investita, è unico nel suo genere, non solo perché vi è coinvolta un’automobile a guida autonoma. Al momento ci sono stati in tutto soltanto quattro morti causate dal malfunzionamento di veicoli di questo tipo – l’ultima il 23 marzo scorso. La differenza è che negli altri tre casi la vittima era sempre stata un supervisore o un tecnico che si trovava alla guida del mezzo. Il caso di Tempe, invece, segna il primo caso nella storia in cui un’automobile a guida autonoma abbia investito e ucciso qualcuno.

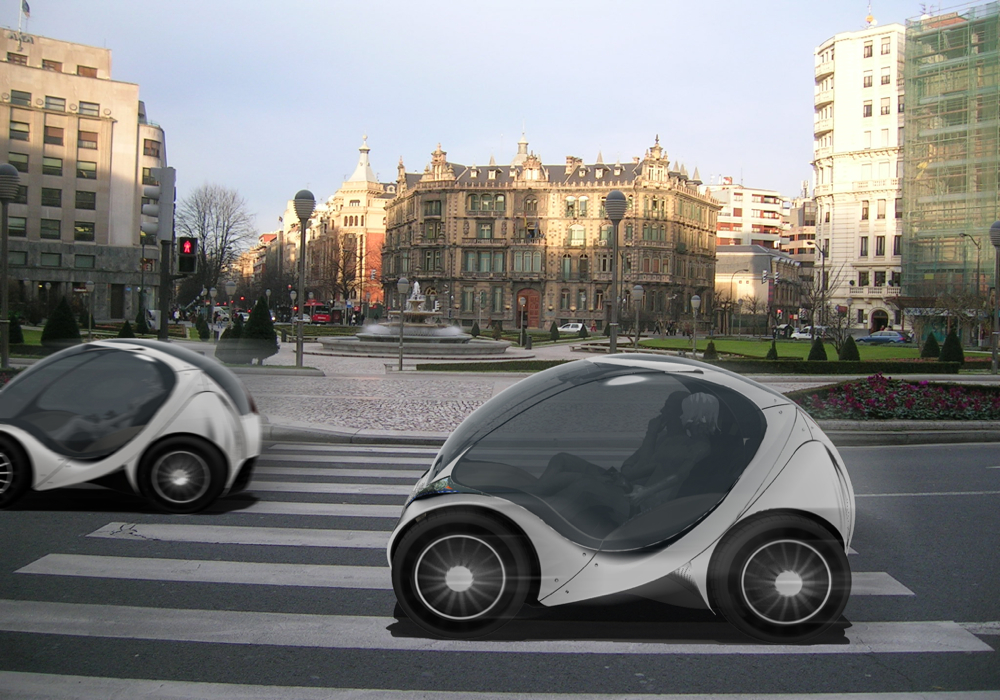

Al momento questo tipo di tecnologia esiste in diverse modalità. Commercialmente molte automobili sono già dotate di sistemi di assistenza alla guida, mentre a livello sperimentale esistono vetture con un livello di autonomia maggiore, per le quali, però, è sempre prevista la presenza di un supervisore umano che prenda il controllo dell’auto in caso di emergenza. Il vantaggio di un sistema di trasporto sempre più automatizzato è chiaro. Solo in Italia nel 2016 sono stati registrati 175.971 incidenti con lesioni, con un totale di 3.283 morti per cause che vanno dalla semplice distrazione alla guida in stato di ebrezza. Raramente si tratta di un guasto meccanico.

Per questa ragione, quando si parla dell’introduzione sulle strade di veicoli dotati anche solo di un sistema di assistenza alla guida, non si sta semplicemente parlando di rendere un lungo tragitto più facile da affrontare per il pilota, ma di salvare statisticamente delle vite. Una simile innovazione crea poi anche una serie di problematiche di tipo legale e solleva legittime domande sull’affidabilità della tecnologia coinvolta.

Nonostante queste incertezze, secondo Gianmarco Veruggio, Dirigente di Ricerca del CNR e scienziato specializzato nel campo della robotica sperimentale, le prospettive per il futuro sono piuttosto positive. “Nel settore [delle autovetture autonome] si parla di cinque livelli [ndr. di sistema di guida]. Il livello uno è quello manuale, mentre il quinto livello è completamente autonomo. Attualmente potremmo considerare il livello di autonomia tra 3 e 4. Si potrà raggiungere il livello 5 solo quando la vettura sarà integrata, mediante connessione con la rete, con l’intelligenza globale del sistema traffico.” Ciononostante, avverte, “Le autovetture a guida autonoma non potranno mai risolvere tutti i problemi. […] Ridurranno il numero d’incidenti, anche se non potranno mai portarlo a zero. Un’autovettura rimane un’autovettura: ha una massa, una velocità e un coefficiente di aderenza col suolo dato dal contatto fra lo pneumatico e l’asfalto.”

Probabilmente è anche per via di questa consapevolezza che le autorità locali di Tempe, dopo un iniziale disorientamento, stanno trattando l’accaduto quasi come se si trattasse di un incidente normale, attribuendo parte della responsabilità al pedone. Secondo il Capo della Polizia di Tempe Sylvia Moir, la vittima, scegliendo di attraversare una strada extraurbana in un punto pericoloso e poco illuminato, ha inevitabilmente messo la propria vita in pericolo.

In casi come questo, a fare la differenza sono i tempi di reazione del pilota, e difficilmente un umano avrebbe potuto fare molto per evitare il pedone. E qui nasce il problema: il computer che controllava l’auto avrebbe dovuto vedere la donna in attraversamento molto prima di un ipotetico autista, ma non si è fermato comunque. Perché?

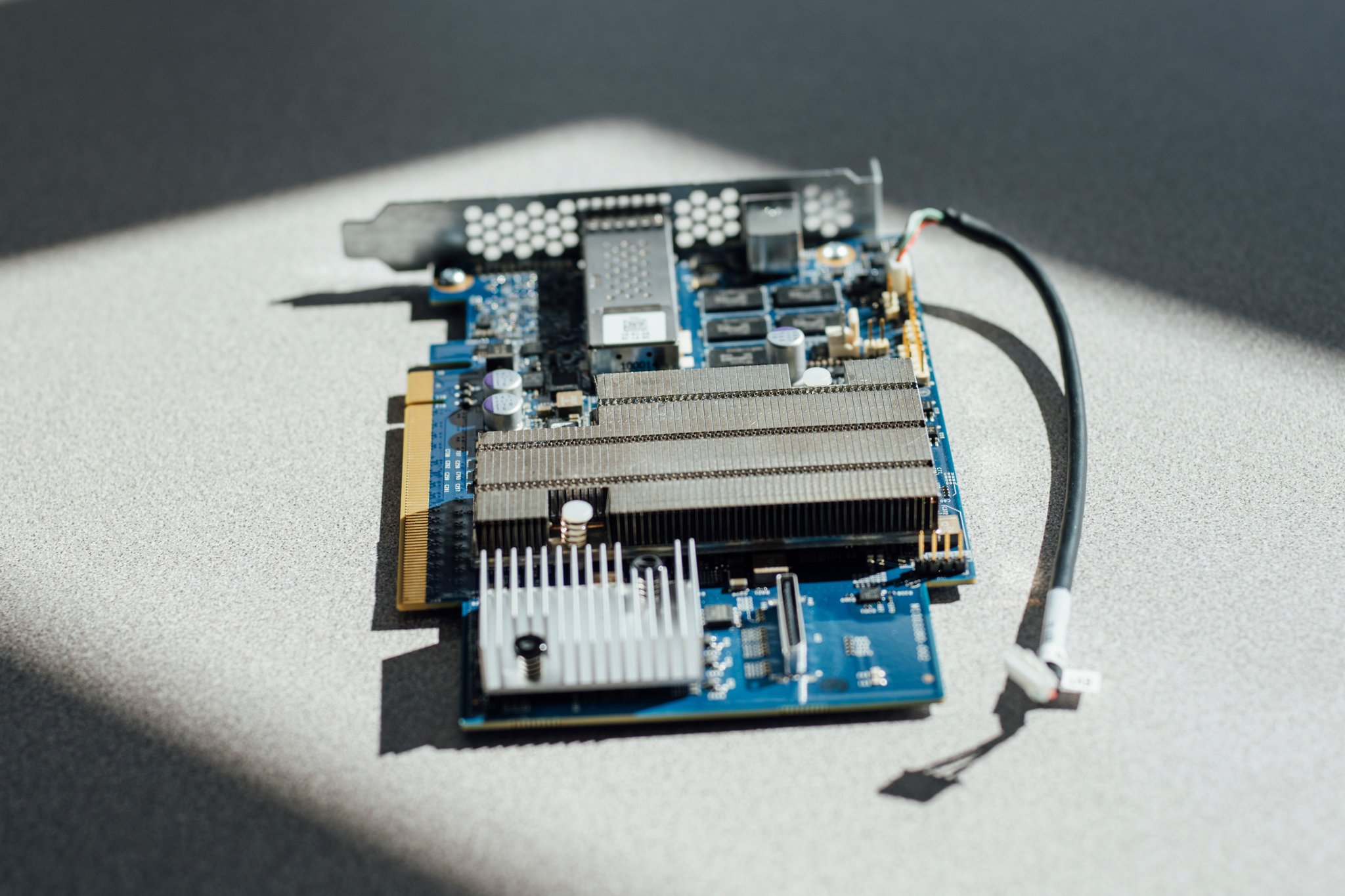

Al momento sembra sia molto difficile rispondere alla domanda. Parte del problema potrebbe avere a che fare con l’apparato sensoriale della macchina, non sempre infallibile: il GPS funziona al suo meglio solo se il cielo è perfettamente sgombro, il LiDAR (un sistema di sensori telemetrici) non funziona con la nebbia, le telecamere hanno bisogno di luce sufficiente e il radar non è particolarmente preciso come sistema di identificazione degli oggetti in movimento nello spazio. Il tutto poi si riduce alla capacità del computer di bordo di gestire i dati. Se questi sensori siano al momento sufficienti a garantire la sicurezza su strada delle persone è materia di dibattito e alcuni esperti, dopo l’incidente, hanno criticato la tendenza delle compagnie americane come Uber a voler accelerare i tempi in un momento delicato in cui la tecnologia impiegata non è ancora affidabile al 100%.

La seconda incognita è il criterio in base al quale la macchina fa le proprie scelte. Mettere la freccia per svoltare a destra è un conto, ma come si comporta il programmatore quando deve istruire il computer sulle manovre da compiere in caso di collisione imminente, in termini di bilanciamento dei rischi e di scelta dei soggetti da esporre a quelli maggiori, insomma, su chi salvare in caso di una collisione imminente?

In uno studio pubblicato su Science nel luglio del 2016, veniva posta proprio questa domanda, in una variazione sul tema del dilemma etico del carrello ferroviario della filosofa inglese Philippa Ruth Foot – un binario al bivio, un carrello lanciato a tutta velocità e la scelta drammatica tra salvare una sola persona, oppure cinque. Supponiamo che un’automobile a guida autonoma con a bordo una famiglia si trovi davanti un bambino che sta incautamente attraversando la strada. Come dovrebbe comportarsi la macchina? Dovrebbe salvare il bambino, facendo sterzare l’auto fuori strada e mettendo in pericolo la famiglia, o dovrebbe porre al primo posto la vita dei suoi proprietari e passargli sopra?

Questo scenario è stato posto dagli autori a un campione di circa duemila persone.

Sorprendentemente la maggior parte degli intervistati ha preferito preservare la vita del bambino rispetto a quella della famiglia. In maniera meno sorprendente, un numero rilevante del campione ha espresso una certa preoccupazione all’idea di comprare un’automobile che valuti la vita del suo proprietario meno di quella di uno sconosciuto, per di più potenzialmente in torto. Questa ovviamente è la risposta umana a un problema posto a una macchina, la quale non è un agente morale.

Una macchina, in questa situazione, forse valuterebbe lo spazio di frenata, mentre un essere umano agirebbe d’istinto. Autisti e pedoni umani non ragionano secondo una programmazione standard o un calcolo delle variabili, e possono comportarsi in modi che potrebbero apparire al computer imprevedibili. Il problema diventa perciò per il computer poter prendere una decisione sulla base di un determinato contesto. Per questa ragione, questi sistemi sono costruiti in modo da poter apprendere nel tempo sulla base dell’esperienza. E qui nascono problemi ancora più complessi.

Nella preistoria dell’intelligenza artificiale, creare un sistema autonomo significava per un programmatore correggere gli errori in modo manuale, attraverso un continuo processo di miglioramento del software. Ma verso la fine degli anni ’70, con l’informatizzazione di diversi campi dell’industria e le crescenti capacità di elaborazione dei computer, si erano resi disponibili grandi quantità di dati utilizzabili per nuove tecniche di apprendimento per le macchine.

Nascevano così le prime reti neurali artificiali. Oggi la macchina, o l’algoritmo, opera su un’architettura di base imposta dallo sviluppatore, ma con l’aumentare delle informazioni fornite riesce a modificare autonomamente la propria programmazione, per fare spazio a nuovi comportamenti appresi. L’effetto collaterale è che in questo modo molti meccanismi decisionali delle macchine diventano oscuri anche ai programmatori stessi.

“Stiamo sviluppando sistemi di intelligenza artificiale basati su reti neurali in grado di evolvere analizzando il modo in cui risolvono i problemi,” spiega Veruggio. “Ciò significa che queste macchine, dopo un certo periodo di tempo, sono diverse da come sono uscite dalla fabbrica. Una macchina che ha lavorato in un posto sarà diversa da quella che ha lavorato in un altro. […] Gli stessi progettisti non sapranno bene come funziona quella macchina al suo interno. Questa è una caratteristica dello sviluppo di questo tipo di intelligenza artificiale.” Questo fenomeno è noto come “modello della scatola nera”: un sistema descrivibile solo sulla base della risposta che una macchina dà a uno stimolo, senza che sia chiaro come questa risposta sia stata elaborata. Imita, seppur in modo limitato, la mente umana, senza la sua coscienza.

Secondo il professor Francesco Vaccarino, docente di matematica al Politecnico di Torino, “Non è che noi non sappiamo cosa c’è nella scatola, ma anche se ci fosse mostrato non sarebbe intellegibile. […] Il numero di variabili [nella decisione] diventa talmente alto che, anche se decidessi di scrivermele, non saprei cosa farmene.” Nel caso di un sistema autonomo, ciò che interessa è il controllo di un processo piuttosto che la spiegazione di come sia stato ottenuto.

È una realtà con cui ci troveremo sempre più a dover convivere, dato che i sistemi guidati da intelligenze artificiali sono ormai diventati una variabile della nostra quotidianità. Pochi stati americani hanno un codice stradale aggiornato per comprendere l’eventualità di un’auto a guida autonoma. In generale, però, nessuna legge federale proibisce la possibilità di circolare con questo tipo di veicoli. L’Europa opera invece sotto la Convenzione di Vienna del 1968, che sul traffico stradale sancisce (per ora) la responsabilità univoca del conducente sul comportamento del mezzo in movimento. Tuttavia, considerando la velocità del progresso nelle automobili a guida autonoma, non si può escludere che questa condizione cambi molto presto.

Tra il 2010 e il 2016 la vendita media dei robot ha mostrato una crescita annua del 12%. Le richieste di brevetto annuali nel campo della robotica sono triplicate nel corso dell’ultimo decennio. La principale spinta è venuta finora dall’industria elettronica e meccanica, ma si può presumere che nei prossimi anni crescerà ancora nell’ambito civile, soprattutto nei trasporti. A livello giuridico, al momento, esiste solo una risoluzione del Parlamento europeo con una serie di raccomandazioni alla Commissione europea in materia di diritto civile sulla robotica. Ma è solo una sorta di invito allo sviluppo di nuove leggi comuni e non ha efficacia vincolante. Nello specifico, più che un problema di sicurezza si pone innanzitutto un problema assicurativo, rispetto al quale gli ordinamenti giuridici dei vari Stati si trovano ancora in alto mare.

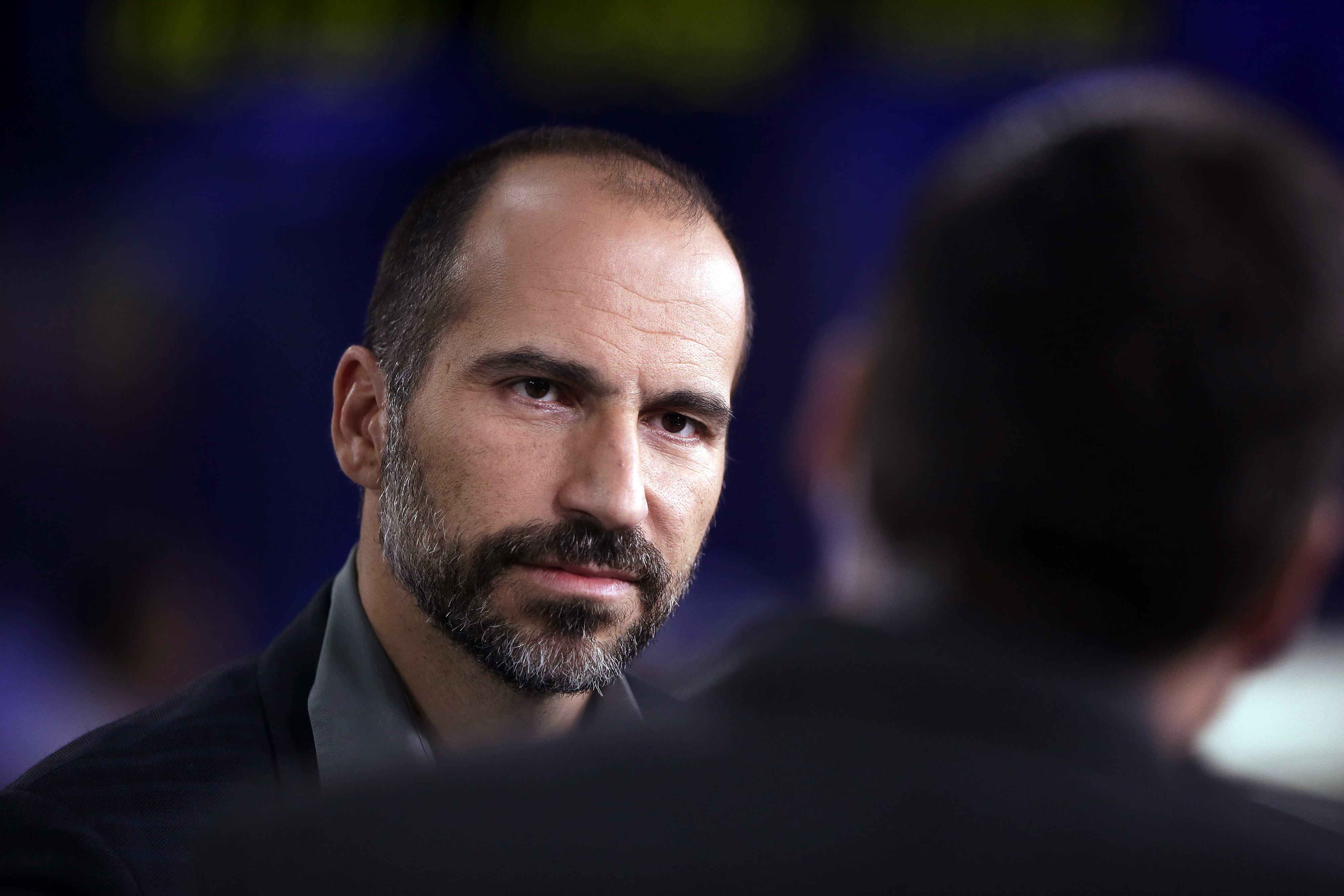

Proprio per questo, in seguito all’incidente di Tempe, il Governatore dell’Arizona, Doug Ducey, ha comunicato in una lettera al CEO di Uber Dara Khosrowshahi la decisione di sospendere in tutto lo Stato i test su strada delle auto a guida autonoma di Uber. Contemporaneamente, la stessa Uber ha annunciato che in California non ne avrebbe più fatti, dato che il California Department of Motor Vehicles aveva comunicato alla società di non poter rinnovare il suo permesso dopo la scadenza del 31 marzo. L’autorizzazione a ulteriori test su strada infatti non sarà rinnovata prima di essere giunti a un verdetto sulle cause dell’incidente.

Qualunque esso sia, Uber dovrà rispondere della gestione dei suoi test su strada, della scelta del personale e della qualità della tecnologia adoperata. Ma gli effetti dell’incidente andranno probabilmente oltre il semplice fatto di cronaca giudiziaria, coinvolgendo anche la pubblica percezione di questa nuova tecnologia. Quello che stiamo attraversando è un periodo di transizione, ma col passare del tempo ci troveremo sempre più a convivere con sistemi in grado di prendere decisioni autonome, in alcuni casi anche affidando loro la nostra sicurezza. Non sembra il caso di evocare rivolte delle macchine e società distopiche, ma forse neanche di sottovalutare la portata del cambiamento che queste intelligenze artificiali produrranno nei prossimi anni. In Europa al momento sono in corso diversi progetti di questo tipo, ma i test sono stati limitati da regolamentazioni più restrittive e da una maggiore cautela degli enti coinvolti. Se è vero che le automobili a guida autonoma cambieranno in meglio la mobilità, la cosa che dobbiamo augurarci è che la tecnologia venga sviluppata con un maggior grado di coscienza dei problemi che potrebbe incontrare.