Quando ho visto Easy, la serie antologica di Netflix che parla di relazioni sociali alla soglia degli anni Venti di questo nuovo secolo, l’episodio che mi ha colpito di più è quello che racconta le fobie di un quartiere benestante di Chicago, sconvolto dal furto di qualche pacco Amazon per mano di un misterioso ladro col cappellino da tennis. Un luogo immaginario e altrettanto realistico dove il livello di criminalità rasenta lo zero, ma che si trasforma nella Harlem degli anni Quaranta agli occhi dei suoi abitanti, che decidono di “farsi giustizia da soli” – con tutte le tremende conseguenze del caso.

Questa storia mi ha colpita perché mostra quanto un’apparente emergenza possa far scaturire nelle persone una voglia di sicurezza malsana, che può finire addirittura per andare contro ai loro stessi interessi. Così ho fatto qualche ricerca su internet, e ho scoperto – con poca sorpresa – che quello che il regista e sceneggiatore della serie, Joe Swanberg, racconta non è troppo lontano dalla realtà.

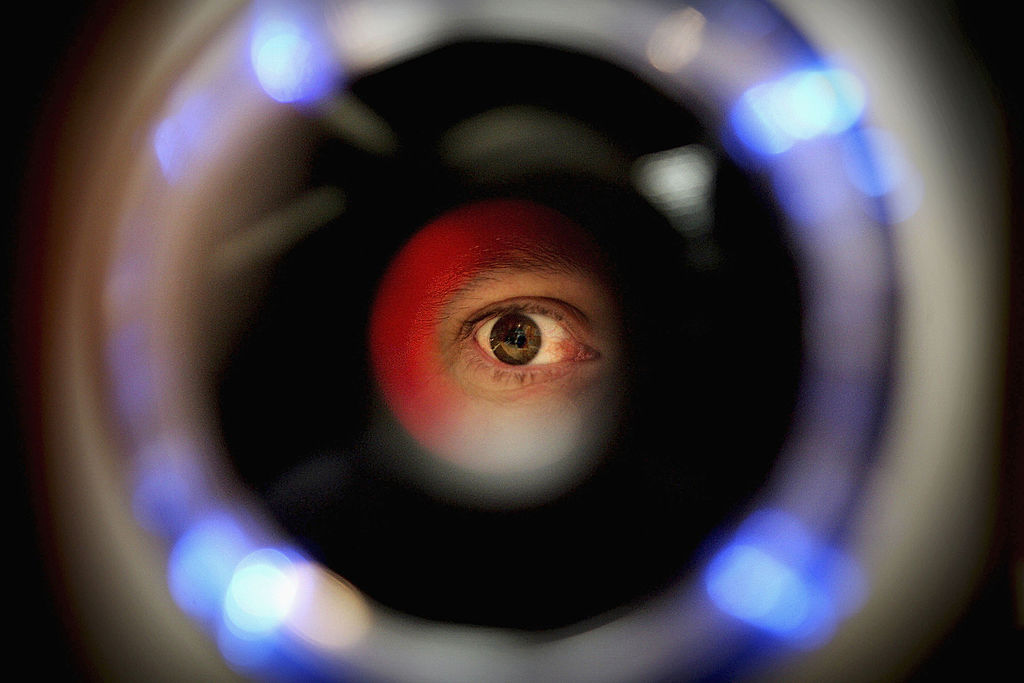

In un tranquillo quartiere a Sud di Ventura Boulevard, infatti, una delle più antiche strade di San Francisco su cui si affacciano ville da milionari, gli abitanti hanno speso una media di 2mila dollari a telecamera per tappezzare le vie di sistemi di sorveglianza che registrano le targhe dei veicoli. Se il fatto di essere intercettato e inserito nel database di una compagnia privata – poi condiviso con le forze dell’ordine – solo per essere passato in una strada non fosse abbastanza inquietante, nello stesso quartiere è diffusa anche Ring, una società di proprietà di Amazon che si occupa di videocitofoni – ne ha installati 100mila in tutto il mondo. Questa, secondo Motherboard avrebbe un accordo con la polizia locale per spronare i cittadini all’installazione dei suoi dispositivi e per Buzzfeed starebbe testando sistemi di riconoscimento facciale in Ucraina.

Non sono sempre le persone però a scegliere di limitare la propria privacy in nome di un’emergenza spesso immaginaria – insieme a quella di amici, conoscenti, passanti, parenti e chiunque suoni alla loro porta, compresi i testimoni di Geova. La culla della società del controllo – più imposta che per scelta – è certamente la Cina, il Paese che ha investito 7,2 miliardi di dollari in due anni nella ricerca di sistemi di sorveglianza. Spesi principalmente nella regione dello XinJiang, dove la cosiddetta “guerra al terrorismo” è diventata un pretesto di repressione, le sperimentazioni stanno venendo estese a tutto il Paese. A inizio mese, ad esempio, è entrata in vigore una legge che impone alle compagnie di telecomunicazioni di sviluppare sistemi di intelligenza artificiale in modo da imporre a chiunque registri una nuova Sim card di inviare uno scan del proprio volto – oltre al nome e ai dati anagrafici già richiesti.

Un altro Paese all’avanguardia in tema di riconoscimento facciale è la Russia, che secondo alcune proiezioni potrebbe addirittura superare i 200 milioni di videocamere installate in Cina. Lo scorso settembre, ad esempio, durante le proteste che hanno accompagnato le elezioni, l’amministrazione di Mosca ha speso 4 milioni di dollari in telecamere indossabili da fornire alle forze dell’ordine per il riconoscimento dei manifestanti. Secondo alcuni, peraltro, sistemi di corruzione pervasivi spingono i poliziotti che hanno accesso a queste tecnologie – e ai database su cui utilizzarle – a vendere i dati delle persone: l’agenzia stampa russa Interfax riporta che nel 2017 due agenti sono stati licenziati per questo motivo. Simili violazioni sono state riscontrate anche negli Stati Uniti, dove centinaia di agenti sono stati segnalati per aver usato i database riservati per indagare su giornalisti scomodi o addirittura ex partner.

Ad accomunare Russia e Cina – e per certi versi anche gli Stati Uniti, seppure in misura decisamente minore – è principalmente l’assenza di una legislazione efficace per la tutela della privacy, che permette alle compagnie, spesso finanziate dallo stesso governo, di comprare una quantità enorme di dati su cui allenare i propri algoritmi, ad esempio da social network come VKontakte. Il motore di ricerca più diffuso in Russia, Yandex, permette di compiere una ricerca inversa delle immagini che non solo propone (come fa Google) i siti sui quali la foto è comparsa, o le fotografie simili ad essa, ma va alla ricerca di quello stesso volto sul web. Questo permette a chiunque di abbinare un volto a un’identità, anche a partire da uno scatto rubato o dal fotogramma ripreso da un video, a patto che sia ragionevolmente nitido e illuminato.

Come ci spiega il professore del Politecnico di Milano Marco Marcon, esperto di Digital Image Processing e biometrica, in Europa e in Italia la ricerca sui sistemi di riconoscimento facciale, sia in ambito accademico che industriale, è indietro rispetto ai luoghi sopracitati proprio perché limitata da normative come il GDPR (General Data Protection Regulation) o le leggi nazionali sulla tutela della privacy. Questo però non significa che sistemi di riconoscimento facciale non siano utilizzati anche da noi e che non dovremmo porci qualche domanda, dal momento che non esiste a oggi una regolamentazione specifica che ponga limiti alla loro applicazione. Proprio a causa di questa mancanza, ad esempio, IBM è stata coinvolta in caso molto simile a quello russo: a inizio anno è emerso che avrebbe scaricato circa un milione di fotografie libere da licenza dal social di fotografi Flickr e le avrebbe utilizzate, senza il consenso dei protagonisti, per allenare i propri algoritmi di riconoscimento facciale. La compagnia si è appellata al Creative Commons, ma non tutti sono concordi nell’affermare che il libero utilizzo di un’immagine coinvolga anche ricerche di deep learning. Non è la sola: la stessa Facebook è stata coinvolta in un processo (di cui ha perso la sentenza in appello) per aver utilizzato questa tecnologia per identificare i volti degli amici da taggare nelle fotografie, senza il consenso esplicito degli utenti. La compagnia di Zuckerberg ha annunciato di voler fare ricorso alla Corte Suprema per evitare di pagare dai mille ai 5mila dollari a utente per 7 milioni di utenti, per un totale che può arrivare fino a 35 miliardi.

Le perplessità non riguardano solo l’uso che le compagnie private fanno del riconoscimento facciale, ma anche i governi, che restano comunque gli enti con accesso al maggior numero di dati sui propri cittadini. Seppure sia ancora una sperimentazione, in diverse città britanniche le telecamere di sorveglianza vengono estensivamente utilizzate a questo scopo. A maggio di quest’anno a Londra un uomo è stato arrestato e condannato a pagare una multa perché, in corrispondenza di queste ultime, si è coperto il viso per non essere riconosciuto. Come scrive Fabio Chiusi in una lunga raccolta su Valigia Blu, sono diverse le notizie di questo tipo che riguardano l’Europa e che fanno riflettere sulle possibili implicazioni di questa tecnologia. Ad esempio, FaceWatch, un sistema di riconoscimento facciale in uso nei negozi britannici, identifica i potenziali ladri sulla base di un database di attenzionati (“people of interest”) e lo segnala al responsabile del negozio affinché possa invitarli a uscire – prima che questi possano commettere qualsiasi tipo di reato, ammesso che l’avrebbero fatto. In Francia e Svezia sono state avviate delle sperimentazioni nelle scuole: nel primo caso il sistema servirebbe a validare l’identità degli studenti e permettere loro l’accesso nell’istituto (previo consenso) e nel secondo a monitorare il tasso di assenze scolastiche (sperimentazione interrotta e sanzionata dal Garante della Privacy per processazione illegale di dati).

Anche in Italia ci sono casi degni di attenzione di esperti, media e cittadini. Un’inchiesta di Raffaele Angius e Riccardo Coluccini, pubblicata su Wired, ha tentato di ricostruire la nebulosa storia di Sari, il sistema automatico di riconoscimento delle immagini in dotazione alla polizia di Stato. A destare preoccupazione in questo caso non è tanto il fatto che le forze dell’ordine abbiano a disposizione simili tecnologie – che come ci spiega sempre il professor Marcon, possono essere usate anche per fornire una bozza di identikit da utilizzare come supporto alle indagini – ma il database su cui fanno riferimento. Questo sarebbe stato composto, secondo quanto ricostruito dai due giornalisti, da 2 milioni di volti italiani e 7 milioni di stranieri che vengono automaticamente fotosegnalati al momento dell’ingresso su suolo italiano. Una sproporzione che rischia di inficiare i risultati della ricerca, creando una sorta di pregiudizio insito nello stesso sistema. D’altronde non sarebbe né la prima volta, né una novità: come spiegano Kate Crawford e Trevor Paglen, autori del progetto Excavating AI, nonostante il mito per cui queste tecnologie sarebbero oggettive e imparziali, il fatto che siano programmate e alimentate da esseri umani le rende altrettanto soggette ai pregiudizi generati dalla società e dalle sue caratteristiche culturali. In diverse ricerche è emerso che questi sistemi tendono a discriminare: uno studio dell’Mit ha riscontrato che l’identificazione risulta errata nell’1% nei casi di maschi bianchi e nel 35% nel caso di donne di colore e lo stesso risultato è stato confermato da una ricerca effettuata su Idemia, un algoritmo utilizzato negli Stati Uniti, in Australia e in Francia, che non sembra essere in grado di funzionare se il soggetto in questione è afrodiscendente.

Il punto della riflessione che deve nascere, sia in ambito giuridico e legislativo che etico e sociologico, deve essere come riuscire a bilanciare sicurezza, efficienza, privacy e rispetto dei diritti civili. Laddove non ci sono, sono necessarie leggi ad hoc che stabiliscano i principi di liceità su cui si devono basare le applicazioni di questa tecnologia, che mette in discussione un diritto umano fondamentale. Prima di tutto, è importante stabilire che tipo di immagini possano essere inserite nel database, dove possano essere raccolte e come assicurarsi di avere il consenso informato dei cittadini – fornendo loro una scelta reale, e non solo apparente come avviene spesso con le informative che di fatto costituiscono una conditio sine qua non all’utilizzo dei servizi. In secondo luogo è importante definire quanto a lungo le immagini possano essere conservate e chi può avervi accesso. Infine, forse la cosa più complessa, è necessario comprendere come evitare di contagiare il sistema con i pregiudizi e le debolezze umane. In Europa, dove già esiste il GDPR, è fondamentale trovare gli strumenti per assicurarsi che questo venga rispettato in tutte le sue applicazioni.

Un esempio è dato dalla notizia di quest’anno dell’investimento di 17 milioni di euro da parte di SEA, la compagnia che gestisce gli aeroporti di Linate e Malpensa. Con questi soldi verranno acquistati sistemi di riconoscimento biometrico facciale al fine di identificare i passeggeri in modo veloce durante l’imbarco. Nulla di male di per sé, ma in assenza di una normativa specifica – o della piena applicazione di questa – è difficile stabilire i limiti entro i quali la compagnia, che entrerebbe in possesso di dati sensibili (ovvero quelli utili a rivelare l’identità di qualcuno, in questo caso il volto abbinato ai dati anagrafici) di migliaia di persone ogni giorno, possa agire.

Quello che viene messo in discussione dall’uso scorretto di questo genere di tecnologie, di fatto, è il diritto all’anonimato. Se anche lo fanno in nome della sicurezza, avere la possibilità di transitare da un aeroporto, una stazione, un negozio o anche solo una strada senza essere registrati e potenzialmente identificati non è un diritto di secondaria importanza. Alla base della nostra identità di esseri umani c’è anche la necessità di scegliere con chi condividere determinate informazioni sul nostro conto, quando e come; il diritto a non essere sospettati e cacciati da un negozio prima ancora di aver commesso qualsiasi tipo di reato, quello a non essere indagati nel nostro intimo senza un motivo, a non subire una perquisizione senza un mandato giudiziario. I sistemi di riconoscimento facciale potrebbero rendere queste aspettative irreali nel concreto, cambiando radicalmente anche il nostro modo di percepire lo spazio pubblico, quello privato e la differenza tra i due.