Nell’ultima – spesso contestata – stagione di Black Mirror, l’Intelligenza Artificiale è protagonista indiscussa dell’episodio Rachel, Jack and Ashley Too. Ashley O, interpretata da Miley Cyrus, è una pop idol di fama mondiale che vorrebbe abbandonare la carriera creata a tavolino dalla zia/manager e sperimentare generi musicali diversi da quelli che le fanno vendere milioni di dischi, ma viene costantemente controllata e tenuta prigioniera in una gabbia dorata. In seguito a un suo tentativo di ribellione, viene avvelenata, mandata in coma chimico e rimpiazzata da ologrammi che sfornano nuovi successi sfruttando le sue stesse idee grazie a una macchina che percepisce e decodifica le onde cerebrali, Ashley Eternal. A cantare continua a essere Ashley O, anzi, Ashley Eternal, ma per il pubblico il risultato non cambia: viva o in coma, la beniamina delle teenager prosegue a pubblicare hit, perché non c’è alcuna differenza tra la sua ‘vera’ voce e quella ricreata dall’Intelligenza Artificiale.

Il futuro distopico e a tratti apocalittico descritto da Black Mirror rientra a pieno titolo nella cifra stilistica della serie, con un appiglio alla realtà: se il concetto alla base di Ashley Too è infatti pura fantascienza, quello che caratterizza Ashley Eternal è basato su tecnologie esistenti. È la stessa Google a dichiarare che stiamo vivendo in una “AI-First age”: gli investimenti delle aziende nel settore del machine learning entro il 2020 supereranno i 46 miliardi, accrescendo ulteriormente la potenza di quello tsunami tecnologico che già da qualche anno ha investito le nostre vite; gli ambiti di applicazione sono ormai pressoché illimitati, e la musica non fa certo eccezione. La moltitudine di software e programmi a disposizione, se da un lato arricchisce in maniera esponenziale le capacità espressive degli artisti, dall’altro solleva dubbi circa una loro possibile futura sostituzione e questi, a loro volta, una domanda: quanto il timore relativo alla macchina che prende il sopravvento sul compositore risulta fondato

Aiva è il primo compositore virtuale di musica classica e sinfonica iscritto a una società per la gestione collettiva del diritto d’autore, l’istituto francese SACEM (Société des Auteurs, Compositeurs et Éditeurs de Musique): compone brani originali basandosi sulle partiture di grandi compositori – Mozart, Bach, Beethoven, Vivaldi – e potrebbe, un domani, completare opere rimaste incompiute come la Sinfonia n.8 di Schubert. La sua tecnologia si basa su algoritmi di deep learning, in cui interagiscono molteplici reti neurali artificiali, ovvero i sistemi che imitano il funzionamento del cervello umano. La scorsa estate Taryn Southern, lanciata dal talent American Idol e diventata una star di YouTube, ha debuttato con l’album pop I AM AI, totalmente suonato e prodotto dal programma open source Amper, dove il contributo della cantante si è limitato agli arrangiamenti e alla voce. Nel 2016, il sistema di IA sviluppato da Sony, Flow Machines, ha costruito il brano “Daddy’s Car” basandosi solo sulle canzoni dei Beatles. Lo stesso sistema ha poi creato un intero album, Hello World, curato dal compositore francese Benoit Carré con lo pseudonimo SKYGGE, che ha coinvolto numerosi artisti tra cui Kiesza e Stromae, e dallo scienziato François Pachet, da poco diventato direttore del laboratorio di ricerca tecnologica di Spotify dedicato alla scoperta di nuovi generi musicali. Il lavoro di Carré è stato accolto positivamente sia dal pubblico che dalla critica; per Alex Marshall della BBC è “il primo valido album prodotto da un robot”, ma nella sua intervista a Carré è lo stesso compositore a sottolineare come l’apporto umano sia stato vitale per aggregare le tracce, dare loro struttura ed emozione: senza le persone, le canzoni di Flow Machine avrebbero rischiato di essere spazzatura o di rimanere senz’anima.

Questi sono solo alcuni esempi degli esperimenti che si stanno compiendo negli ultimi anni. La musica generata dall’IA, tuttavia, non costituisce nulla di nuovo o di futuristico. Già negli anni Cinquanta i compositori sperimentali scrivevano musica utilizzando modelli statistici randomizzati, e appena qualche decennio più tardi David Bowie avrebbe collaborato con l’ex CTO di Universal Music Group Ty Roberts per creare Verbasizer, un programma che gli permetteva di inserire fino a 25 frasi e gruppi di parole in una serie di finestre, riordinate poi casualmente dal programma in nuove combinazioni liriche potenzialmente significative. Ciò che cambia, oggi, sono gli ingenti investimenti di etichette discografiche, servizi di streaming e società di venture capital per sviluppare prodotti musicali scalabili e generati dall’IA.

Anche Google, con il progetto interno Magenta, sta studiando algoritmi di deep learning per realizzare canzoni, disegni e altre opere: uno dei suoi modelli musicali più famosi, Performance RNN, usa le reti neurali per fornire tempi e dinamiche espressive, simili a quelli umani, a file MIDI altrimenti statici e generati da una macchina. Tutti gli strumenti di Magenta sono open-source, e la diretta conseguenza è una rinnovata democratizzazione della musica, a cui si avvicina pure un’ondata di dilettanti desiderosa di condividere il proprio contenuto online; parallelamente, nel mondo delle startup, aziende come Splice e Amadeus Code stanno costruendo assistenti virtuali integrati con IA ad uso e consumo di musicisti e produttori come Zedd e Flavio Morana, in arte The Buildzer.

Due dei punti più dolenti in qualsiasi processo creativo sono tempi e costi, e l’IA può aiutare a ridurre entrambi i fattori in modo significativo, soprattutto in un’industria – quella discografica – i cui numeri vengono ormai tenuti alti solo dallo streaming. I dati del Global Music Report 2019 di IFPI parlano chiaro: nel 2018 l’incremento del comparto è stato del 9,7% con un totale di ricavi totali pari a 19,1 miliardi di dollari. Lo streaming continua a crescere in maniera esponenziale, mettendo una pezza al calo ormai fisiologico del fisico e fissando l’aumento al 34% rispetto al 2017, arrivando a rappresentare ormai il 47% del totale dell’industria. Sebbene il dibattito nel mondo della musica e discografia sia attualmente a uno stadio embrionale, molti media – dal più generalista The Guardian al più specifico Billboard – si stanno domandando se un domani la figura del musicista e del compositore ‘tradizionale’ verrà spazzata via dall’algoritmo.

Vero è che la questione per ora riguarda una nicchia di autori più avanguardisti, slegati dalle logiche mainstream del consumo di massa, che stanno esplorando le possibilità offerte dalla musica generata da software di IA. La collaborazione uomo/macchina viene in generale vissuta come un modo per indagare nuovi orizzonti creativi, o, stando alle parole del CEO e cofondatore di Amper Drew Silverstein, come un’occasione affinché chiunque in tutto il mondo possa esprimersi attraverso la musica, indipendentemente da background, esperienza o disponibilità economica. I più critici accusano invece l’IA distruggere la sovrastruttura romantica connessa all’artista che scrive e compone i propri pezzi, scordandosi però di considerare la difficile gestazione che ogni evoluzione ha richiesto. “La maggior parte dei musicisti, accademici o compositori, ha sempre avuto l’idea che la creazione musicale dovesse essere intrinsecamente umana”, osserva David Cope, Professore Emerito presso l’Università della California, “e in qualche modo anche il computer a suo tempo equivaleva a una minaccia”. Se il timore legato al computer avesse inibito l’inventiva dei musicisti e le loro sperimentazioni, oggi non avremmo generi come la musica elettronica – incapace di vivere se svincolata dal digitale – e festival come il Sónar di Barcellona, che all’interno della sua area Sónar+D dedicata a tecnologia, creatività e business, già da diversi anni si interroga sulle future applicazioni dell’IA in ambito musicale.

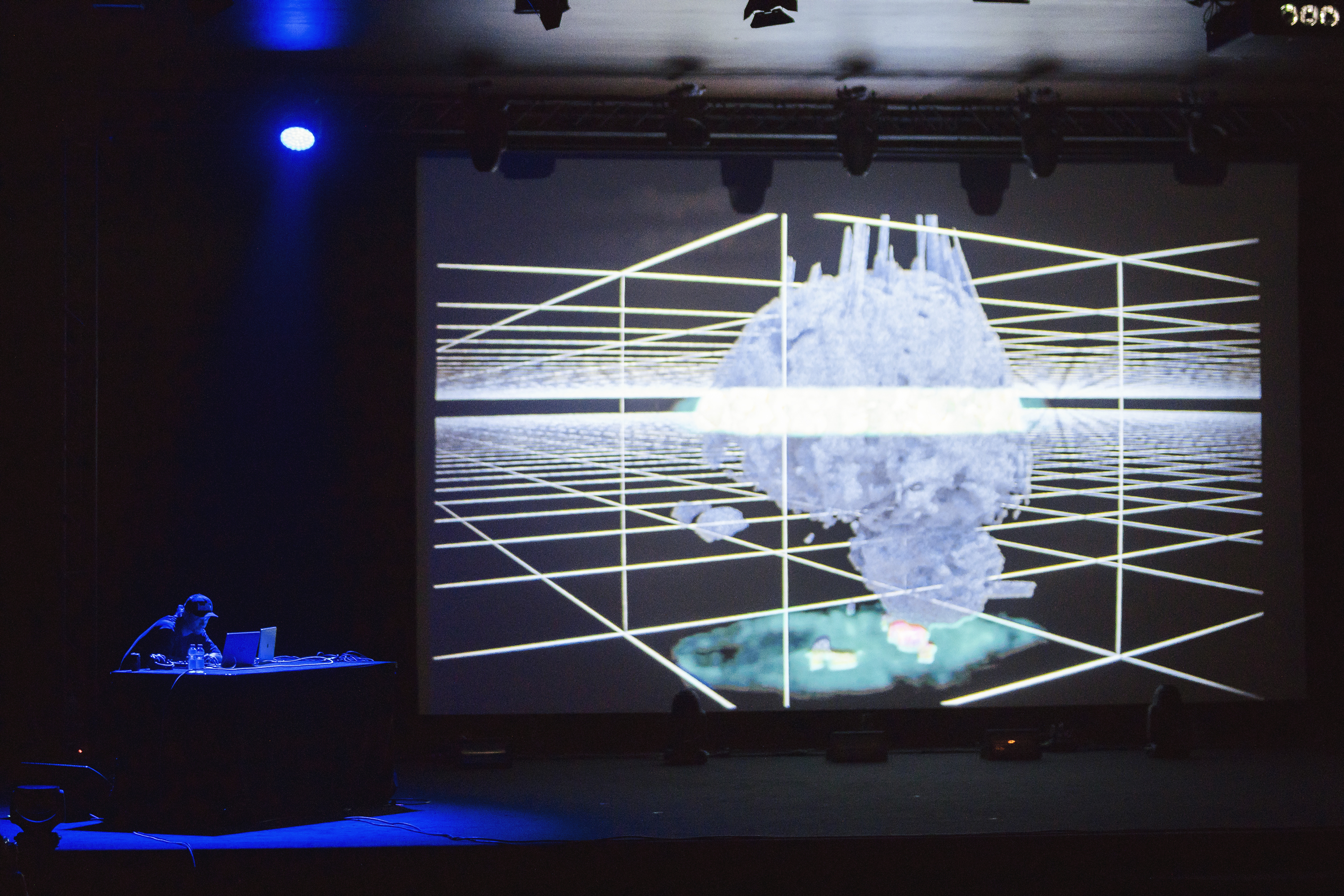

Tra gli ospiti dell’edizione da poco conclusa c’era anche l’artista elettronica Holly Herndon, che insieme al compagno Mat Dryhurst ha presentato il suo nuovo album PROTO, creato in collaborazione con Spawn, un’IA ospitata in un PC per videogame modificato programmata per apprendere e rielaborare input sonori e generare output totalmente originali. Per Herndon “Spawn è equiparabile a un bambino che impara dalle voci dei propri genitori e collaboratori musicali: in tal senso lo consideriamo un performer, i compositori rimaniamo comunque Mat e io. Spawn reinterpreta gli input che gli forniamo e allo stesso tempo interagisce con i musicisti: il suo scopo principale è integrarsi nel nostro gruppo, e per fare in modo che ciò avvenisse ho voluto aumentare il numero di collaboratori insieme a me sul palco, proprio per compensare la sua presenza con una forte componente umana”.

Il concetto di “simbiosi” ricorre spesso nei discorsi di Herndon e Dryhurst, che vedono l’IA come uno strumento creativo per indagare il presente e spingere le loro performance oltre i limiti prestabiliti, senza che questo prevalga sull’umanità del musicista. È del medesimo avviso anche Jules Laplace, artista, programmatore e sviluppatore che ha lavorato alla sintesi vocale per il progetto Spawn: invitato al Sónar+D insieme alla compositrice Bethany Barrett, Laplace ritiene che l’IA sia stata oggetto di una narrazione eccessivamente allarmista da parte di film, libri e serie tv, quando invece si tratta di un’enorme opportunità che – oltre a dare spazio a nuove professionalità – permette agli artisti di esplorare frontiere musicali fino a ieri sconosciute. “Il sintetizzatore,” spiega Laplace, “negli anni Sessanta è stato accompagnato dalle stesse idiosincrasie da parte dei tradizionalisti: ciononostante è riuscito a integrarsi perfettamente nell’universo musicale contribuendo a far nascere una generazione di artisti che l’ha eletto a suo mezzo d’espressione”.

Inoltre, non bisogna dimenticare che “l’IA non ha autonomia”, spiega Bethany Barrett, “è ancora una replica di voci e suoni che conosciamo, e in tal senso non potrebbe vivere senza l’apporto umano iniziale. Sono due universi in grado di coesistere, senza che uno debba per forza prevalere sull’altro”. L’interaction designer, programmatore e DJ giapponese Daito Manabe, che in coppia con il neuroscienziato dell’Università di Kyoto Yukiyasu Kamitani ha elaborato il progetto Dissonant Imaginary – un sistema che decodifica i segnali dalla corteccia visiva, elaborandoli e proiettandoli sotto forma di immagini in tempo reale – insiste sull’importanza della figura del musicista, che ora produce “una creatività più sofisticata poiché capace di utilizzare la musica generata dall’IA in maniera inaspettata: ha a disposizione una scelta più ampia di metodi di creazione musicale, e resta comunque al centro del processo”. L’interesse del pubblico, per Manabe, è inscindibile dalla storia personale dell’artista, rispettato proprio in quanto arbitro della cultura e del contesto, non solo del suono.

Sia Herndon che Manabe hanno attratto sui rispettivi palchi una nutrita folla di affezionati, coinvolti da sconcertanti esibizioni – quella di Herndon in particolare, più simile a teatro sperimentale che a un concerto – umanizzate da una narrazione mai così potente. Ecco forse come l’IA rimodellerà il settore: non tanto eliminando professionisti o posti di lavoro, quanto lasciandoci la libertà di avventurarci lungo percorsi poco battuti, approfondendo derive creative che prima non avremmo potuto permetterci. Alcune ritrosie sono normali e connaturate all’uomo: il cambiamento della fruizione musicale dal vinile allo streaming, così come la nascita dell’elettronica e di diversi tipi di musica d’avanguardia, inizialmente sono sempre stati guardati con sospetto dai tradizionalisti. La sensazione degli addetti ai lavori è tuttavia che l’impatto dell’IA sull’industria musicale si tradurrà in una maggiore accessibilità ed efficienza, che a loro volta consentiranno un’ulteriore elevazione intellettuale. Nel panorama attuale e nell’immediato futuro l’AI non diverrà sinonimo di pigrizia o di inerzia, né sostituirà la classica figura del compositore: rimaniamo ancora – e rimarremo per molto tempo – gli unici autori delle nostre narrazioni creative, dotati però della possibilità di aumentarle e di renderle più rilevanti e significative. Tutte cose che l’IA, da sola, non potrebbe fare.